学习和适应

如前所述,ANN 完全受到生物神经系统(即人脑)工作方式的启发。人脑最令人印象深刻的特征是学习,因此 ANN 也具有同样的特征。

ANN 中的学习是什么?

基本上,学习意味着在环境发生变化时进行并适应自身变化。ANN 是一个复杂系统,或者更准确地说,我们可以说它是一个复杂的自适应系统,它可以根据通过它的信息改变其内部结构。

为什么它很重要?

作为一个复杂的自适应系统,ANN 中的学习意味着处理单元能够根据环境的变化改变其输入/输出行为。当构建特定网络时,由于激活函数以及输入/输出向量固定,ANN 中学习的重要性会增加。现在,为了改变输入/输出行为,我们需要调整权重。

分类

它可以定义为通过寻找同一类样本之间的共同特征来学习将样本数据区分为不同类别的过程。例如,为了进行 ANN 的训练,我们有一些具有独特特征的训练样本,而为了进行测试,我们有一些具有其他独特特征的测试样本。分类是监督学习的一个例子。

神经网络学习规则

我们知道,在 ANN 学习过程中,为了改变输入/输出行为,我们需要调整权重。因此,需要一种方法来修改权重。这些方法称为学习规则,它们只是算法或方程式。以下是神经网络的一些学习规则 −

赫布学习规则

这条规则是最古老、最简单的规则之一,由唐纳德·赫布于 1949 年在其著作《行为的组织》中提出。它是一种前馈、无监督学习。

基本概念 −这条规则基于赫布提出的一项提议,他写道 −

"当细胞 A 的轴突足够接近以刺激细胞 B 并反复或持续地参与激发它时,一个或两个细胞中就会发生一些生长过程或代谢变化,使得 A 作为激发 B 的细胞之一的效率提高。"

从上述假设中,我们可以得出结论,如果两个神经元同时激发,则它们之间的连接可能会加强,如果它们在不同时间激发,则可能会减弱。

数学公式 −根据赫布学习规则,以下是在每个时间步骤增加连接权重的公式。

$$\Delta w_{ji}(t)\:=\:\alpha x_{i}(t).y_{j}(t)$$

这里,$\Delta w_{ji}(t)$ = 连接权重在时间步骤 t

增加的增量$\alpha$ = 正且恒定的学习率

$x_{i}(t)$ = 时间步骤 t

时突触前神经元的输入值$y_{i}(t)$ = 同一时间步骤 t

时突触前神经元的输出感知器学习规则

此规则是 Rosenblatt 提出的一种具有线性激活函数的单层前馈网络的监督学习算法的误差校正方法。

基本概念 − 由于本质上是监督式的,因此为了计算误差,需要将期望/目标输出与实际输出进行比较。如果发现任何差异,则必须更改连接的权重。

数学公式 −为了解释其数学公式,假设我们有"n"个有限输入向量 x(n),以及其期望/目标输出向量 t(n),其中 n = 1 到 N。

现在可以计算输出"y",如前所述,基于净输入,并且应用于该净输入的激活函数可以表示如下 −

$$y\:=\:f(y_{in})\:=\:\begin{cases}1, & y_{in}\:>\: heta \0, & y_{in}\:\leqslant\: heta\end{cases}$$

其中 θ 为阈值。

可以在以下两种情况下更新权重 −

情况 I − 当 t ≠ y,然后

$$w(new)\:=\:w(old)\:+\;tx$$

情况 II − 当 t = y 时,则

权重不变

Delta 学习规则(Widrow-Hoff 规则)

它由 Bernard Widrow 和 Marcian Hoff 引入,也称为最小均方 (LMS) 方法,用于最小化所有训练模式的误差。它是一种具有连续激活函数的监督学习算法。

基本概念 − 该规则的基础是梯度下降法,它会永远持续下去。Delta 规则更新突触权重,以最小化输出单元的净输入和目标值。

数学公式 −为了更新突触权重,delta 规则由以下公式给出:

$$\Delta w_{i}\:=\:\alpha\:.x_{i}.e_{j}$$

这里 $\Delta w_{i}$ = 第 i 个模式的权重变化;

$\alpha$ = 正且恒定的学习率;

$x_{i}$ = 来自突触前神经元的输入值;

$e_{j}$ = $(t\:-\:y_{in})$,期望/目标输出与实际输出之间的差异 $y_{in}$

上述 delta 规则仅适用于单个输出单元。

可以在以下两种情况下更新权重 −

情况 I − 当 t ≠ y 时,则

$$w(new)\:=\:w(old)\:+\:\Delta w$$

情况 II − 当 t = y 时,则

权重不变

竞争学习规则(赢家通吃)

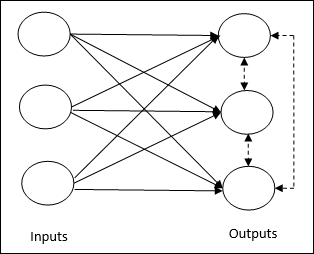

它涉及无监督训练,其中输出节点试图相互竞争以表示输入模式。要理解这个学习规则,我们必须了解竞争网络,如下所示 −

竞争网络的基本概念 −这个网络就像一个单层前馈网络,输出之间有反馈连接。输出之间的连接是抑制类型的,用虚线表示,这意味着竞争对手永远不会支持自己。

竞争学习规则的基本概念 − 如前所述,输出节点之间会存在竞争。因此,主要概念是在训练期间,对给定输入模式具有最高激活的输出单元将被宣布为获胜者。该规则也称为赢家通吃,因为只有获胜的神经元会更新,其余神经元保持不变。

数学公式 − 以下是该学习规则数学公式的三个重要因素 −

成为赢家的条件 −假设一个神经元 $y_{k}$ 想要成为赢家,那么就会有以下条件 −

$$y_{k}\:=\:\begin{cases}1 & if\:v_{k}\:>\:v_{j}\:for\:all\:j,\:j\: eq\:k\0 & else\end{cases}$$

这意味着如果任何神经元,比如 $y_{k}$ ,想要获胜,那么它的诱导局部场(求和单元的输出),比如 $v_{k}$,必须是网络中所有其他神经元中最大的。

权重总和条件 −竞争性学习规则的另一个约束是,特定输出神经元的权重总和将为 1。例如,如果我们考虑神经元 k,则 −

$$\displaystyle\sum\limits_{j}w_{kj}\:=\:1\:\:\:\:\:\:\:\:for\:all\:k$$

获胜者的权重变化 − 如果神经元对输入模式没有反应,则该神经元不会发生学习。但是,如果某个神经元获胜,则相应的权重将按如下方式调整

$$\Delta w_{kj}\:=\:\begin{cases}-\alpha(x_{j}\:-\:w_{kj}), & if\:neuron\:k\:wins\0, & if\:neuron\:k\:losses\end{cases}$$

此处 $\alpha$ 为学习率。

这清楚地表明,我们通过调整权重来偏向获胜的神经元,如果存在神经元损失,则我们无需费心重新调整其权重。

Outstar 学习规则

该规则由 Grossberg 提出,与监督学习有关,因为期望的输出是已知的。它也被称为 Grossberg 学习。

基本概念 −此规则适用于排列在一层中的神经元。它专门设计用于产生 p 个神经元层的期望输出 d。

数学公式 − 此规则中的权重调整计算如下

$$\Delta w_{j}\:=\:\alpha\:(d\:-\:w_{j})$$

这里 d 是期望的神经元输出,$\alpha$ 是学习率。