自适应共振理论

该网络由 Stephen Grossberg 和 Gail Carpenter 于 1987 年开发。它基于竞争并使用无监督学习模型。顾名思义,自适应共振理论 (ART) 网络始终对新学习开放(自适应),而不会丢失旧模式(共振)。基本上,ART 网络是一个向量分类器,它接受输入向量,并根据它与存储的哪个模式最相似将其归类为其中一个类别。

工作原理

ART 分类的主要操作可分为以下几个阶段 −

识别阶段 − 将输入向量与输出层中每个节点处呈现的分类进行比较。如果神经元的输出与所应用的分类最匹配,则输出为"1",否则输出为"0"。

比较阶段 − 在此阶段,将输入向量与比较层向量进行比较。重置的条件是相似度小于警戒参数。

搜索阶段 − 在此阶段,网络将搜索重置以及上述阶段完成的匹配。因此,如果没有重置并且匹配相当好,则分类结束。否则,将重复该过程,并且必须发送其他存储的模式以找到正确的匹配。

ART1

它是一种 ART,旨在对二进制向量进行聚类。我们可以通过它的架构来理解这一点。

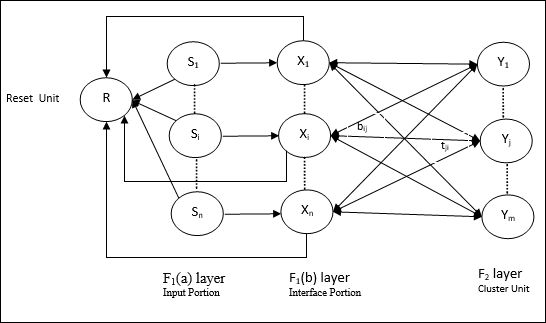

ART1 的架构

它由以下两个单元组成 −

计算单元 − 它由以下 −

输入单元(F1 层) − 它进一步具有以下两个部分 −

F1(a) 层(输入部分) − 在 ART1 中,此部分不会进行任何处理,而只有输入向量。它连接到 F1(b) 层(接口部分)。

F1(b) 层(接口部分) −此部分将输入部分的信号与 F2 层的信号相结合。F1(b) 层通过自下而上的权重 bij 连接到 F2 层,F2 层通过自上而下的权重 tji 连接到 F1(b) 层。

集群单元(F2 层) − 这是一个竞争层。选择具有最大净输入的单元来学习输入模式。所有其他集群单元的激活都设置为 0。

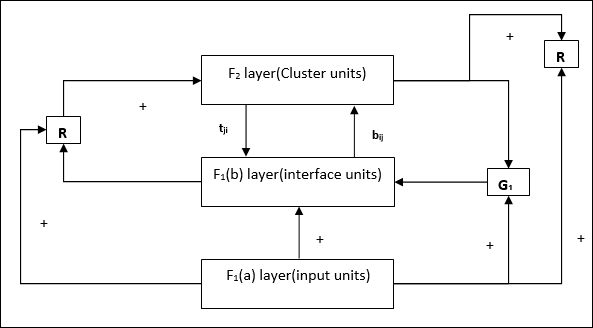

重置机制 − 此机制的工作基于自上而下的权重和输入向量之间的相似性。现在,如果这种相似度小于警戒参数,则不允许集群学习模式,并且会发生休息。

补充单元 − 实际上,重置机制的问题在于,F2 层必须在某些条件下被抑制,并且在某些学习发生时也必须可用。这就是为什么除了重置单元 R 之外,还添加了两个补充单元,即 G1 和 G2。它们被称为 增益控制单元</b>。这些单元接收和发送信号到网络中的其他单元。 '+' 表示兴奋信号,而 '−' 表示抑制信号。

使用的参数

使用以下参数 −

n − 输入向量中的分量数

m − 可形成的最大簇数

bij − 从 F1(b) 到 F2 层的权重,即自下而上的权重

tji − 从 F2 到 F1(b) 层的权重,即自上而下的权重

ρ −警戒参数

||x|| − 向量 x 的范数

算法

步骤 1 − 初始化学习率、警戒参数和权重,如下所示 −

$$\alpha\:>\:1\:\:and\:\:0\:< ho\:\leq\:1$$

$$0\:<\:b_{ij}(0)\:<\:\frac{\alpha}{\alpha\:-\:1\:+\:n}\:\:and\:\:t_{ij}(0)\:=\:1$$

步骤 2 −当停止条件不成立时,继续步骤 3-9。

步骤 3 − 对每个训练输入继续步骤 4-6。

步骤 4 − 将所有 F1(a) 和 F1 单元的激活设置为如下

F2 = 0 且 F1(a) = 输入向量

步骤 5 − 从 F1(a) 到 F1(b) 层的输入信号必须像这样发送

$$s_{i}\:=\:x_{i}$$

步骤 6 −对于每个被抑制的 F2 节点

$y_{j}\:=\:\sum_i b_{ij}x_{i}$ 条件为 yj ≠ -1

步骤 7 − 当重置为真时,执行步骤 8-10。

步骤 8 − 为所有节点 j

找到 yJ ≥ yj 的 J步骤 9 −再次计算 F1(b) 上的激活,如下所示

$$x_{i}\:=\:sitJi$$

步骤 10 − 现在,在计算向量 x 和向量 s 的范数后,我们需要检查重置条件,如下所示 −

如果 ||x||/ ||s|| < 警戒参数 ρ,theninhibit node J 并转到步骤 7

否则,如果 ||x||/ ||s|| ≥警戒参数 ρ,然后继续。

步骤 11 − 节点 J 的权重更新可以按如下方式完成 −

$$b_{ij}(new)\:=\:\frac{\alpha x_{i}}{\alpha\:-\:1\:+\:||x||}$$

$$t_{ij}(new)\:=\:x_{i}$$

步骤 12 − 必须检查算法的停止条件,可能如下所示 −

- 权重没有任何变化。

- 不对单位执行重置。

- 已达到最大时期数。