机器学习算法的统计比较

预测建模和数据驱动决策建立在机器学习算法之上。这些算法使计算机能够通过从数据中学习模式和相关性来提供精确的预测和有见地的信息。由于有许多不同的算法可用,因此了解它们的独特品质并选择最适合特定情况的算法非常重要。

通过对每种算法的性能进行客观评估,统计比较在算法选择中起着至关重要的作用。我们可以通过使用统计测量对比算法来评估算法的优势、缺点和对特定任务的适用性。它使我们能够将算法有效性指标(如召回率、精确度和准确度)转化为数字形式。在本文中,我们将对机器学习算法进行统计比较。

了解统计比较

评估机器学习算法有效性的一个关键组成部分是统计比较。使用统计指标客观评估和对比各种算法有效性的技术称为统计比较。它让我们能够公平地比较事物,并从结果中得出重要的结论。

关键指标和评估技术

准确率、精确度、召回率和 F1 分数:大多数情况下,分类工作都使用这些指标。精确度计算准确预测的阳性案例的百分比,而准确度评估算法预测的总体准确度。召回率通常称为敏感度,用于衡量算法识别阳性案例的能力。F1 分数通过将准确度和召回率结合为一个统计数据,提供对分类能力的公平评估。

混淆矩阵:混淆矩阵对算法的分类结果进行了彻底的细分。通过呈现真阳性、真阴性、假阳性和假阴性数字,可以更好地理解算法在多个类别中的性能。

ROC 曲线和 AUC:使用接收者操作特性 (ROC) 曲线以图形方式描绘了不同分类级别的真阳性率和假阳性率之间的权衡。曲线下面积 (AUC) 显示了算法在所有潜在阈值上的性能。AUC 值越高,分类性能越好。

交叉验证:交叉验证是一种评估算法在多组数据上的表现的方法。交叉验证通过将数据集分成多个部分并在各种组合上迭代训练和评估算法,有助于评估方法的通用性并减少过度拟合。

偏差-方差权衡:统计比较中的一个基本思想是偏差-方差权衡。它与模型检测数据中细微模式的能力(低偏差)与其对噪声或微小变化的敏感性(高方差)之间的平衡有关。为了确保算法在训练数据和未知数据上都能有效执行,必须找到理想的平衡。

机器学习算法的统计比较

线性回归

回归分析使用此技术作为模拟因变量与一个或多个自变量之间联系的基本方法。为了减少平方误差的总和,线性回归尝试将直线拟合到数据点。可以使用统计指标(如判定系数 (R 平方) 和系数的 p 值)来评估模型的相关性和拟合优度。

多项式回归

当变量之间的连接存在曲线模式时,多项式回归很有用。这种方法可以通过使用多项式项和线性项来捕捉变量之间更复杂的相关性。假设检验可用于评估多项式项的统计显著性,从而让我们选择最合适的多项式次数。

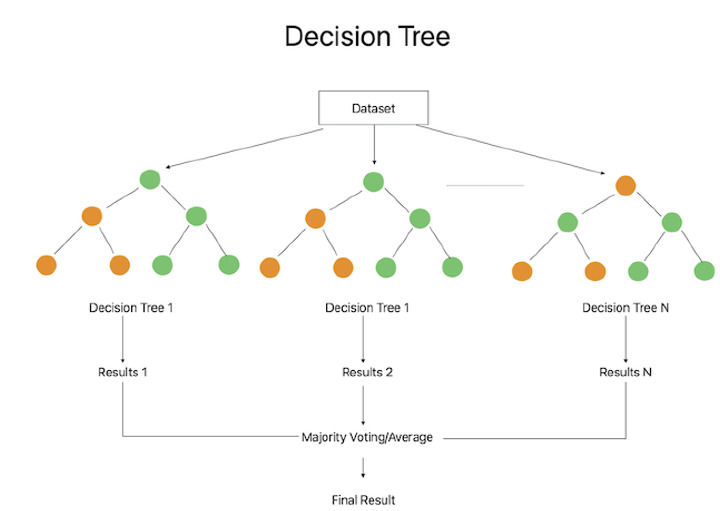

决策树回归

通过递归地将特征空间划分为区域,决策树回归为回归问题提供了非线性解决方案。决策基于每个内部节点的特征值,从而产生多个分支。通过对与输入特征值相对应的整个区域的目标值进行平均,可以得出最终的预测值。可以使用均方误差 (MSE) 和 R 平方等统计指标来评估决策树回归的有效性和可解释性。

逻辑回归

逻辑回归是一种通用方法,可预测输入数据与二元或多类目标变量之间的关系。它确定特定实例属于特定类的概率。可以使用准确度、精确度、召回率和 F1 分数等统计指标来评估系统的分类性能。

支持向量机

SVM 是一种强大的算法,它可以在高维空间中找到最佳超平面并将数据分成几组。通过最大化类别之间的边距,SVM 旨在提供强大的分类。用于评估 SVM 性能的重要统计指标包括准确度、精确度、召回率和 F1 分数。 SVM 还可以使用核技术解决特征之间的非线性关系。

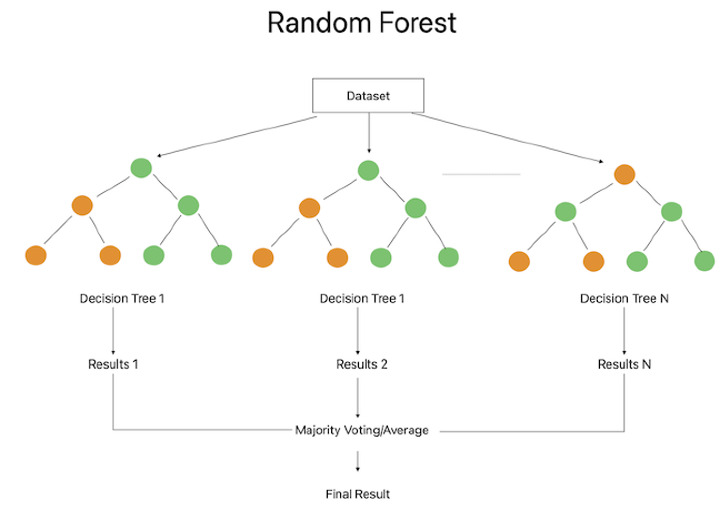

随机森林

使用随机森林集成方法将多棵决策树组合在一起以获得预测。每棵决策树都是使用随机选择的特征和信息子集创建的。可以使用准确度、精确度、召回率和 F1 分数等统计指标来评估随机森林分类器的性能。该程序根据基尼指数或信息增益提供有关特征重要性的见解。

结论

为特定任务选择最佳机器学习算法的过程在很大程度上依赖于统计比较。我们可以通过进行全面的统计研究,公正地评估各种算法的功能和特性。比较统计数据可以揭示许多参数,包括 ROC 曲线下面积、F1 分数、召回率、准确率和精确率。这些指标使我们能够评估算法的预测准确性、对各种数据分布的适应性以及对噪声或异常值的抵抗力。我们还可以通过使用交叉验证等统计比较技术来衡量算法的泛化效果,并确保它在未经测试的数据上表现良好。