CNTK - 测量性能

本章将解释如何在 CNKT 中测量模型性能。

验证模型性能的策略

在构建 ML 模型后,我们习惯使用一组数据样本对其进行训练。通过这种训练,我们的 ML 模型可以学习并得出一些一般规则。当我们向模型提供新样本(即与训练时提供的样本不同的样本)时,ML 模型的性能很重要。在这种情况下,模型的行为会有所不同。它可能无法对这些新样本做出良好的预测。

但模型也必须适用于新样本,因为在生产环境中,我们将获得与用于训练目的的样本数据不同的输入。这就是原因,我们应该使用一组与我们用于训练目的的样本不同的样本来验证 ML 模型。在这里,我们将讨论两种用于创建用于验证 NN 的数据集的不同技术。

保留数据集

这是创建用于验证 NN 的数据集的最简单方法之一。顾名思义,在这种方法中,我们将保留一组用于训练的样本(例如 20%)并使用它来测试我们的 ML 模型的性能。下图显示了训练和验证样本之间的比率 −

保留数据集模型确保我们有足够的数据来训练我们的 ML 模型,同时我们将拥有合理数量的样本来获得对模型性能的良好测量。

为了包括在训练集和测试集中,从主数据集中选择随机样本是一种很好的做法。它确保训练和测试集之间的均匀分布。

以下是我们使用 scikit-learn 库中的 train_test_split 函数生成自己的保留数据集的示例。

示例

来自 sklearn.datasets 导入 load_iris

iris = load_iris()

X = iris.data

y = iris.target

来自 sklearn.model_selection 导入 train_test_split

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=1)

# 上面的 test_size = 0.2 表示我们提供 20% 的数据作为测试数据。

从 sklearn.neighbors 导入 KNeighborsClassifier

从 sklearn 导入 metrics

classifier_knn = KNeighborsClassifier(n_neighbors=3)

classifier_knn.fit(X_train, y_train)

y_pred = classifier_knn.predict(X_test)

# 提供样本数据,模型将根据该数据进行预测

sample = [[5, 5, 3, 2], [2, 4, 3, 5]]

preds = classifier_knn.predict(sample)

pred_species = [iris.target_names[p] for p in preds] print("Predictions:", pred_species)

输出

Predictions: ['versicolor', 'virginica']

使用 CNTK 时,每次训练模型时,我们都需要随机化数据集的顺序,因为 −

深度学习算法受随机数生成器的影响很大。

训练期间向 NN 提供样本的顺序会极大地影响其性能。

使用保留数据集技术的主要缺点是它不可靠,因为有时我们会得到非常好的结果,但有时我们会得到糟糕的结果。

K 倍交叉验证

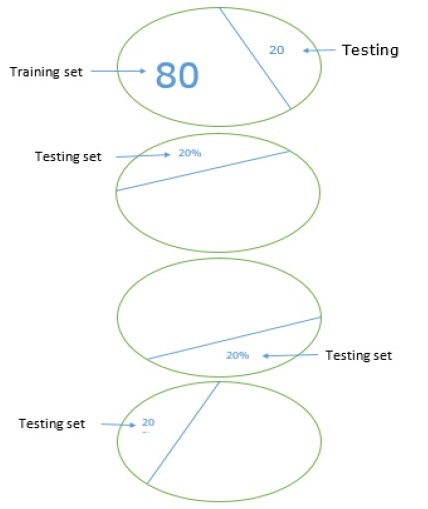

为了使我们的 ML 模型更可靠,有一种称为 K 倍交叉验证的技术。本质上,K 倍交叉验证技术与之前的技术相同,但它会重复多次 - 通常大约 5 到 10 次。下图表示其概念 −

K 折交叉验证的工作原理

可以借助以下步骤理解 K 折交叉验证的工作原理 −

步骤 1 − 与 Hand-out 数据集技术一样,在 K 折交叉验证技术中,首先我们需要将数据集拆分为训练集和测试集。理想情况下,比例为 80-20,即 80% 的训练集和 20% 的测试集。

步骤 2 −接下来,我们需要使用训练集训练我们的模型。

步骤 3 −最后,我们将使用测试集来衡量模型的性能。Hold-out 数据集技术和 k-cross 验证技术之间的唯一区别是,上述过程通常重复 5 到 10 次,最后计算所有性能指标的平均值。该平均值将是最终的性能指标。

让我们看一个带有小数据集的示例 −

示例

from numpy import array

from sklearn.model_selection import KFold

data = array([0.1, 0.2, 0.3, 0.4, 0.5, 0.6, 0.7, 0.8, 0.9, 1.0])

kfold = KFold(5, True, 1)

for train, test in kfold.split(data):

print('train: %s, test: %s' % (data[train],(data[test]))

输出

train: [0.1 0.2 0.4 0.5 0.6 0.7 0.8 0.9], test: [0.3 1. ] train: [0.1 0.2 0.3 0.4 0.6 0.8 0.9 1. ], test: [0.5 0.7] train: [0.2 0.3 0.5 0.6 0.7 0.8 0.9 1. ], test: [0.1 0.4] train: [0.1 0.3 0.4 0.5 0.6 0.7 0.9 1. ], test: [0.2 0.8] train: [0.1 0.2 0.3 0.4 0.5 0.7 0.8 1. ], test: [0.6 0.9]

如我们所见,由于使用了更现实的训练和测试场景,k 倍交叉验证技术为我们提供了更稳定的性能测量,但缺点是,它在验证深度学习模型时需要大量时间。

CNTK 不支持 k 倍交叉验证,因此我们需要编写自己的脚本来执行此操作。

检测欠拟合和过拟合

无论我们使用 Hand-out 数据集还是 k 倍交叉验证技术,我们都会发现用于训练的数据集和用于验证的数据集的指标输出会有所不同。

检测过度拟合

过度拟合的现象是指我们的 ML 模型对训练数据的建模非常好,但在测试数据上表现不佳,即无法预测测试数据的情况。

当 ML 模型从训练数据中学习特定的模式和噪声时,就会发生这种情况在一定程度上,它会对该模型从训练数据推广到新数据(即未见过的数据)的能力产生负面影响。这里,噪声是数据集中不相关的信息或随机性。

以下是两种方法,借助它们我们可以检测我们的模型是否过度拟合 −

过度拟合模型在我们用于训练的相同样本上表现良好,但在新样本(即不同于训练的样本)上表现非常糟糕。

如果测试集上的指标低于我们在训练集上使用的相同指标,则该模型在验证期间过度拟合。

检测欠拟合

我们的 ML 中可能出现的另一种情况是欠拟合。在这种情况下,我们的 ML 模型没有很好地模拟训练数据并且无法预测有用的输出。当我们开始训练第一个时期时,我们的模型将处于欠拟合状态,但随着训练的进行,欠拟合程度将降低。

检测我们的模型是否欠拟合的方法之一是查看训练集和测试集的指标。如果测试集上的指标高于训练集上的指标,则我们的模型将处于欠拟合状态。