DALL-E - 架构

DALL-E 是一个AI模型,可根据用户给出的文本描述生成图片。它是 GPT(生成式预训练 Transformer)系列的一部分,并在 Transformer 模型上工作以创建视觉内容。

DALL-E 主要依赖于以下技术 −

- 自然语言处理 (NLP) − 它帮助模型理解用户给出的文本描述的含义。

- 大型语言模型 (LLM) − 它以一种传达语义信息的方式对文本和图像进行编码。 OpenAI 开发了自己的 LLM,称为 CLIP,它是 DALL-E 的一部分。

- 扩散模型 − 这主要用于生成图像。

对比语言-图像预训练 (CLIP)

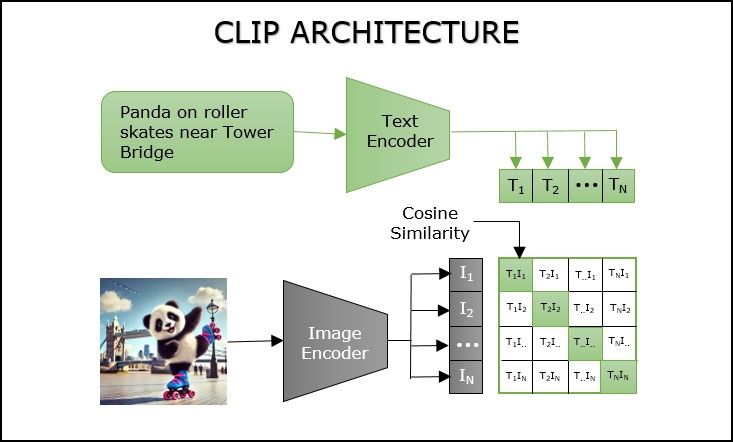

CLIP 是 OpenAI 专为 DALL-E 模型的功能而开发的大型语言模型。它对带有相关标题的多个图像进行训练,以弥合文本描述和图像之间的差距。顾名思义,"对比"模型将给定的文本提示与数据集中现有图像的标题进行比较,以检查输入是否与任何图像标题匹配。每个图像-标题对都分配有一个相似度分数,并选择相似度分数最高的对。为了执行此任务,该模型依赖于两个组件 −

- 文本编码器 −它将用户的文本提示转换为文本嵌入,这些是 DALL-E 可以理解的数值。

- 图像编码器 − 与文本编码器类似,此组件用于将图像转换为图像嵌入。

现在,它比较文本和图像嵌入的值,并检查语义信息的相似性,这称为余弦相似度。下面的表示将帮助您更好地理解 −

DALL-E 的工作原理

DALL-E 负责处理输入数据并将其转换为灵活的数据以执行生成任务。

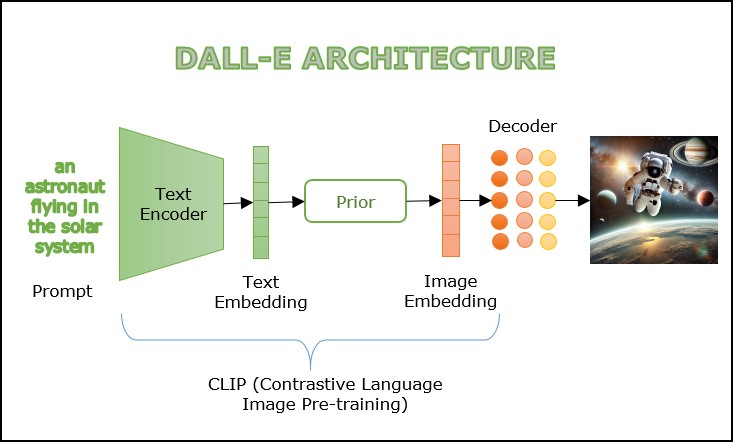

模型的工作流程如下所述 −

- 一旦提供了图像的文本描述,就会将其提供给 CLIP 的文本编码器。使用 NLP 理解提示的含义,然后将其转换为捕获语义含义的高维向量表示。此向量表示称为文本嵌入。

- 接下来,将文本嵌入传递给 prior,这是一种可以从概率分布中采样以生成逼真图像的生成模型。

- 在最后一步中,一旦先前生成的图像嵌入通过扩散解码器,就会生成最终图像。