Gemini Code Assist 如何工作?

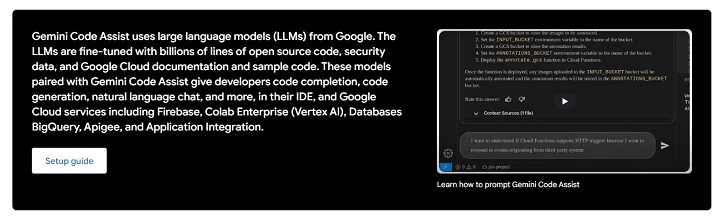

Google 的 Gemini Code Assist 正在利用 AI 和自动化工作流程的强大功能改变开发人员创建、管理和维护代码的方式。它的独特优势在于能够处理多达 100 万个令牌,远远超过 GPT-4 Turbo 和 Claude 3 等竞争模型。无论您是需要帮助创建 API、自动化工作流程还是理解复杂的数据集,Gemini Code Assist 都可以通过基于自然语言的提示和智能推荐来提高效率。

在本章中,我们将了解 Gemini 的工作原理以及支持其功能的核心架构模型。

这些功能如何协同工作?

Gemini Code Assist 作为一个轻量级插件运行,可与领先的 IDE(如 Visual Studio Code、IntelliJ 和 JetBrains 工具)集成。它依靠机器学习模型和上下文分析来了解您的项目结构。让我们看看支持 Gemini 的核心架构模型是什么。

自然语言处理 (NLP) 和代码理解

- Gemini 使用大型语言模型 (LLM),类似于 GPT 等工具中的模型,但针对软件开发任务进行了微调。

- 该模型可识别多种语言的代码结构、语法和语义。

- 它应用上下文 NLP 来理解代码注释和自然语言指令,从而可以根据开发人员的输入建议有意义的代码片段。

- 示例 −如果开发人员输入"连接到 PostgreSQL",Gemini 会为 Python 或 Node.js 提供现成的数据库连接代码片段。

针对特定语言和框架的微调模型

- Gemini 利用针对 Java、Python 和 JavaScript 等特定语言优化的微调 AI 模型。

- 专用插件可处理流行框架(例如 Flask、React、Spring),确保提供高度相关的建议。

- 该系统提供与语言无关的错误检测,这意味着它可以发现多种语言中的逻辑错误。

插件和基于微服务的架构

- 该工具采用模块化、基于微服务的设计,其中各个组件(例如语法检查、调试助手)独立运行。

- 此架构支持按需更新插件,无需中断活动编码会话。

实时模型推理和轻量级部署

- Gemini 在边缘设备上运行推理模型或与基于云的推理引擎集成,具体取决于部署。

- 该工具通过尽可能在本地处理建议来确保低延迟响应,而代码重构等资源密集型操作可以卸载到云端。

企业上下文集成

- Gemini Code Assist 了解企业安全架构、API 配置和策略模式的概念。

- 这种上下文智能可确保 Gemini 给出的建议和代码建议与组织的基础架构保持一致。

- 示例 −从事 CRM-API 集成工作的开发人员将根据与公司 CRM 平台相关的安全策略收到具体建议。

API 配置

- 开发人员可以使用通俗易懂的语言描述通过 Apigee 生成 API 代理。

- 如果现有 API 对象不足,Gemini 将建议增强或扩展 API 的方法,从而减少开发时间和精力。

- 示例 − 在向 API 添加身份验证时,Gemini 会根据 Apigee 中可用的策略提供现成的代码片段和配置指南。

自动维护

- 通过主动建议,Gemini Code Assist 可确保您的自动化流程保持高效。

- 它可以在集成过程中建议优化或识别错误。

- 示例 − Gemini 可能会建议从自动化管道中删除不必要的数据转换,从而使工作流程更加顺畅。

Gemini Code Assist 的架构

Gemini Code Assist 的架构反映了 Google 在多模态 AI 模型方面的进步,能够处理和生成各种数据类型的输出,包括文本、代码和图像。以下是核心架构组件的细分 −

多模态功能

与许多仅限于文本输入的 NLP 模型不同,Gemini 可以处理结构化和非结构化数据。这意味着开发人员可以使用 JSON 文件、代码库甚至文档来高效地生成输出。

内存和令牌管理

Gemini 能够处理多达 100 万个令牌,从而实现扩展对话和深入的代码分析。这使得它适用于需要详细文档解析的大规模代码库或自动化流程。

Google DeepMind 协作

该架构与 DeepMind 在强化学习方面的专业知识合作,确保模型可以随着每次交互而改进。Gemini 还采用基于注意力的转换器,以更快、更准确地理解上下文。

支持 Gemini Code Assist 的平台

Gemini Code Assist 深深嵌入 Google Cloud 生态系统中,使其可在支持企业工作流的各种平台上使用。以下是可以访问 Gemini 的一些主要服务 −

Apigee API 管理

Apigee 充当 API 的代理,Gemini 通过自然语言提示帮助设计、管理和增强 API 代理。开发人员可以以最小的努力修改或迭代现有 API。

应用程序集成

借助 Google 的 iPaaS 解决方案,开发人员可以通过用简单的语言指定他们的需求来创建自动化流程。Gemini 处理技术实现,自动生成变量和任务。

跨平台兼容性

Gemini Code Assist 可在移动设备、桌面和云平台上运行,确保开发人员无论在哪里工作都可以访问它。这种灵活性对于需要在不同环境中使用一致工具的远程开发团队至关重要。

ML 模型和训练架构

Gemini Code Assist 背后的 ML 模型是 Google DeepMind 广泛研究的成果。以下是该模型及其演变的一些技术方面 −

模型变体

Gemini 的每个变体都针对不同的工作负载进行了优化。

- Ultra − 适用于企业级自动化和大型数据集。

- Pro − 适用于具有中等数据处理需求的中端应用程序。

- Nano − 适用于移动应用程序和边缘设备的轻量级变体。

预训练和微调

- Gemini 在多种数据集上进行了预训练,包括代码存储库、API 规范和文档。

- 根据特定的企业需求进行微调,确保与目标用例保持一致。

基于 Transformer 的架构

- 该模型使用多层 Transformer 来捕获长距离依赖关系,使其能够为复杂的代码库生成准确的输出。

- Gemini 采用与 BERT 或 Codex 类似的 Transformer 神经网络架构,擅长理解顺序数据。

- 系统处理部分输入(甚至是不完整的代码行),通过分析前后代码块来预测最相关的完成。

- 双向编码确保该工具不仅可以从过去的输入中学习,还可以预测未来的需求。

随着 Google 不断完善此工具,我们可以期待更复杂的功能,这些功能将在未来重新定义企业发展。